Los desafíos del Big Data

En la era del Big Data, donde las organizaciones se inundan con información de diversas fuentes, garantizar la calidad de los datos se ha convertido en un imperativo crucial. Si bien las 5 V's clásicas (Volumen, Velocidad, Variedad, Veracidad y Valor) más las 2 V's adicionales, proporcionan un marco inicial para comprender los desafíos del Big Data, es necesario profundizar en los aspectos específicos que afectan la calidad de los datos en entornos de grandes datos.

En este artículo, exploraremos los principales desafíos del Big Data que enfrentan las organizaciones y analizaremos algunas estrategias para abordarlos.

Los desafíos del Big Data hacia una calidad de los datos

Incertidumbre en la procedencia

La naturaleza distribuida y heterogénea de las fuentes de Big Data, provenientes de sensores, redes sociales, transacciones web y otras verdientes, dificulta la identificación precisa del origen de los datos. Esta falta de trazabilidad dificulta la evaluación de la confiabilidad y la autenticidad de la información, especialmente cuando se trata de datos no estructurados o semiestructurados.

Por ejemplo, en la industria farmacéutica, donde la calidad de los datos es vital para la seguridad y eficacia de los medicamentos, la incertidumbre en la procedencia de datos representa un riesgo significativo. Imagine un ensayo clínico internacional que recopila datos de pacientes de diversos centros en todo el mundo. Si no se sabe con precisión el origen de cada conjunto de datos, es difícil verificar su autenticidad, identificar sesgos y rastrear errores. Esto puede llevar a decisiones erróneas sobre la aprobación de medicamentos, daños a la reputación de la empresa y retrasos en el desarrollo, con graves consecuencias para la salud pública y la economía. Para mitigar estos riesgos, las empresas farmacéuticas deben implementar medidas estrictas para garantizar la trazabilidad de la procedencia de los datos, como protocolos claros, herramientas de seguimiento y capacitación del personal. Solo así se podrá garantizar la integridad de los ensayos clínicos, proteger la salud de los pacientes y mantener la confianza en el desarrollo de nuevos medicamentos.

Los desafíos del Big Data son multifacéticos y requieren de un enfoque integral y proactivo

Duplicidad y redundancia

Con la ingesta masiva de datos desde diversas fuentes, la duplicación y redundancia de información se convierten en problemas comunes. Esto no solo aumenta el volumen de datos a procesar, sino que también puede generar inconsistencias y sesgos en los análisis, afectando la precisión de los resultados.

Por ejemplo, en la industria minorista, donde el manejo de datos de ventas y transacciones es crucial, la duplicidad y redundancia representan un lastre para la eficiencia. Imagine una cadena de tiendas con datos de ventas de diversos sistemas. Si no se gestionan adecuadamente, es probable que haya duplicaciones, como registros de la misma transacción en diferentes sistemas o registros incompletos. Esto genera problemas como mayor volumen de datos, incoherencias en la información y dificultades en el análisis, lo que afecta el rendimiento, la toma de decisiones y la rentabilidad. Para mitigarlo, las empresas minoristas pueden implementar un sistema de gestión de datos maestro (MDM), establecer estándares de datos, utilizar herramientas de limpieza de datos y promover una cultura de calidad de datos. Solo así se podrá optimizar las operaciones, mejorar la eficiencia y obtener información precisa para el crecimiento del negocio.

Errores y anomalías

Los errores en la captura, transmisión y procesamiento de datos son inevitables, y su impacto se amplifica en entornos de Big Data. Errores tipográficos, valores atípicos, datos faltantes o inconsistentes pueden tener un efecto significativo en la calidad de los análisis y la toma de decisiones.

Incompletitud y falta de contexto

Los datos de Big Data a menudo están incompletos o carecen del contexto necesario para su correcta interpretación. Esto puede dificultar la comprensión del significado real de los datos y limitar su utilidad para el análisis.

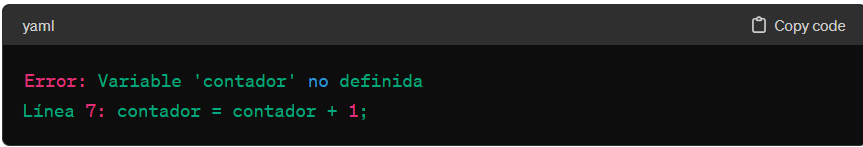

La incompletitud y la falta de contexto en la programación son como un rompecabezas con piezas faltantes. Funciones sin documentación, variables con nombres genéricos y algoritmos sin explicaciones dificultan la comprensión, colaboración y mantenimiento del código. Adoptar buenas prácticas como la documentación clara, nombres descriptivos y código modular es crucial para crear un código completo, contextualizado y fácil de entender.

Evolución y desactualización

Los datos dinámicos y en constante cambio, como los datos de las redes sociales o los datos del mercado financiero, presentan un desafío único para la calidad. Es fundamental implementar mecanismos para actualizar y validar los datos de manera continua, asegurando que los análisis se basen en información precisa y relevante.

El código en constante cambio, como un río que fluye, presenta desafíos de desactualización: incompatibilidades, vulnerabilidades y dificultades de mantenimiento. Para afrontarlos, se requieren actualizaciones periódicas, pruebas exhaustivas, documentación clara y una arquitectura modular. Así, el software evoluciona de forma segura, confiable y mantenible a largo plazo.

Sesgos y discriminación

Los sesgos algorítmicos y la discriminación inadvertida pueden introducirse en los sistemas de análisis de datos, especialmente cuando se utilizan modelos de aprendizaje automático entrenados con datos sesgados o incompletos. Es crucial implementar técnicas de detección y mitigación de sesgos para garantizar la equidad y la justicia en el análisis de datos.

Por ejemplo, los sesgos algorítmicos en la justicia penal, como cuando un algoritmo discrimina a personas de minorías étnicas o entornos desfavorecidos por datos sesgados, son un problema real que perpetúa las desigualdades en el sistema judicial. Implementar medidas para detectar y mitigar estos sesgos, como el análisis de datos, la anonimización y la evaluación del algoritmo, es crucial para garantizar la equidad y la justicia en los procesos penales.

Cuestiones de privacidad y seguridad

La recopilación, el almacenamiento y el análisis de grandes volúmenes de datos personales plantean importantes desafíos de privacidad y seguridad. Es importante implementar medidas de seguridad robustas y cumplir con las regulaciones de privacidad de datos, como GDPR y CCPA, para proteger la información confidencial y evitar el uso indebido de los datos.

A través del siguiente vídeo, verás cómo Guillermo Cernuda, Director de Operaciones, Compliance Officer y DPO en DoGood y tutor del Máster en Big Data Sanitario habla sobre el uso de datos y las preguntas que hay que hacerse en materia de privacidad y seguridad a la hora de tratarlos.

Necesidad de talento en Big Data

El avance de la Ciencia de Datos en los últimos años ha sido tan rápido y ha impactado de tal manera que los profesionales en este campo se han convertido en el "unicornio" que todas las empresas buscan.

Los expertos en Big Data se encuentran entre los profesionales mejor pagados de la industria y esto se debe a que una de sus principales funciones radica en analizar grandes volúmenes de datos con distintas soluciones tecnológicas para poder determinar si la información es valiosa, con el objetivo de mejorar distintos tipos de procesos en la empresa.

Los Expertos en Big Data se han convertido en el "unicornio" que todas las empresas buscan

Si bien los desafíos del Big Data son complejos, existen estrategias efectivas que las organizaciones pueden implementar para mejorar la calidad de sus datos y aprovechar al máximo el potencial del Big Data:

- Implementación de un programa de gobierno de datos: Establecer un marco sólido de gobierno de datos que defina estándares, políticas y procedimientos para la gestión de datos, incluyendo la calidad. Esto proporciona una base sólida para la gestión consistente y efectiva de la calidad de los datos en toda la organización.

- Adopción de herramientas de calidad de datos: Utilizar herramientas especializadas de calidad de datos para la limpieza, validación, enriquecimiento y monitoreo de la calidad de los datos. Estas herramientas pueden automatizar tareas tediosas y que requieren mucho tiempo, mejorando la eficiencia y la precisión de la gestión de la calidad de datos.

- Integración de datos de forma eficaz: Diseñar e implementar una arquitectura de datos que facilite la integración de datos provenientes de diversas fuentes de manera consistente y segura. Esto minimiza la duplicación, los errores y las inconsistencias, mejorando la calidad general de los datos.

- Capacitación y desarrollo de personal: Brindar a los profesionales las habilidades y los conocimientos necesarios para gestionar la calidad de datos en entornos de Big Data. Esto incluye la formación en técnicas de limpieza de datos, análisis de calidad de datos y herramientas de calidad de datos.

- Fomento de una cultura de calidad: Crear una cultura organizacional donde la calidad de los datos sea considerada una prioridad estratégica

El gran desafío del Big Data es multifacético y requiere de un enfoque integral y proactivo. Al comprender los desafíos específicos que enfrentan las organizaciones y adoptar estrategias efectivas de gestión de la calidad de datos, las empresas pueden transformar sus datos en activos valiosos que impulsan la innovación, el crecimiento y la toma de decisiones estratégicas.